본 글은 https://arxiv.org/abs/2304.08485 내용을 기반으로 합니다. 본 논문은 NeurIPS 2023 oral에서 소개되었습니다.

혹시 잘못된 부분이나 수정할 부분이 있다면 댓글로 알려주시면 감사하겠습니다.

본 눈문은 language-image instruction-following data를 생성하기 위해 GPT-4를 사용한다.

그리고 vision encoder와 LLM을 연결한 LLaVA(Large Language and Vision Assistant)를 소개한다.

LLaVA는 Science QA에서 SOTA 성능을 달성하였다.

Abstract

machine이 생성한 instruction-following data를 사용한 instruction tuning LLM들은 새로운 task에서 zero-shot 성능 향상을 보여준다. 하지만, 이러한 아이디어는 멀티모달 분야에서는 덜 탐구되었다. 본 연구는 language-only GPT-4를 사용하여 multimodal language-image instruction-following data를 생성하기 위한 첫 번째 시도를 제시한다. 이렇게 생성된 데이터에 대한 instruction tuning을 통해, 범용적인 visual and language 이해를 위한 vision encoder와 LLM을 연결한 end-to-end로 훈련된 large multimodal model인 LLaVA(Large Language and Vision Assistant)를 소개한다. visual instruction following에 대한 향후 연구를 촉진하기 위해, 다양하고 도전적인 application-oriented task를 통해 두 가지 평가 벤치마크를 구축한다. LLaVA는 인상적인 멀티모달 채팅 기능을 보여주며 때로는 보이지 않는 image/instruction에 대해 multimodal GPT-4의 동작을 보여주며 생성된 multimodal instruction-following dataset에서 GPT-4와 비교하여 85.1%의 상대 점수를 산출한다. Science QA에 대해 파인튜닝했을 때, LLaVA와 GPT-4의 시너지 효과로 92.53%의 SOTA 성능을 달성한다. GPT-4를 이용해 생성한 visual instruction tuning data, LLaVA 모델 및 코드를 공개한다.

* instruction-following data : 모델이 특정한 지시나 명령을 이해하고 따를 수 있도록 설계된 데이터. 이 데이터는 instruction(질문이나 요청)과 이에 대한 following(답변이나 설명)으로 구성되며 모델이 지시 사항에 맞춰 task를 수행할 수 있도록 훈련하는 데 사용. 이렇게 구성된 데이터는 모델이 다양한 유형의 질문이나 요청을 이해하고 요구사항을 충족하는 방식으로 답변하도록 훈련.

* instruction tuning : insruction-following data를 사용해 모델을 훈련하는 과정. instruction-following data를 통해 모델을 학습하면, 모델이 특정 명령이나 질문을 이해하고 그에 맞춰 응답하도록 조정. 이를 통해 모델은 사용자의 의도를 더 잘 파악하고 그에 맞춰 더 적합한 답변을 생성하는 능력을 갖춤.

* application-oriented task : application은 응용, oriented는 ~을 지향하는, ~에 맞춘이라는 의미로 실제 응용 상황에서 사용할 수 있는 문제나 작업을 의미.

1. Introduction

AI의 핵심 목표 중 하나는 멀티모달 vision-and-language instruction을 효과적으로 따르며 인간의 의도에 맞춰 다양한 real-world task를 수행할 수 있는 범용적인 assistant를 개발하는 것이다.

이를 위해, AI 분야는 언어를 보강한 foundation vision model을 개발하는데 관심이 증가하는 것을 목격해왔다. classification, detection, segmentation, and captioning 뿐만 아니라 visual generation 및 editing과 같은 실세계 visual understanding에서 강력한 성능을 보여주었다. 최신 연구 자료에 대해서는 Computer Vision in the Wild 목록을 참고하기 바란다. 이 연구 방향에서 각 task는 하나의 대형 vision model에 의해 독립적으로 해결되며 task instruction은 모델 설계에 암묵적으로 반영된다. 또한 언어는 이미지 내용을 설명하는 데에만 사용된다. 이를 통해 언어는 언어 의미론에 시각적 신호를 매핑하는 데 중요한 역할을 할 수 있지만, 이는 일반적으로 제한된 상호작용성과 사용자 instruction에 대한 적응성을 갖춘 고정된 인터페이스를 갖는 모델로 이어진다.

* fixed interface : 모델이나 시스템이 사용자와 상호작용하는 방식이 제한적이고 변경이 어렵게 설계된 형태. 이로써 사용자의 instruction에 대해 제한된 상호작용성과 적응력을 보임.

반면에, LLM들은 언어가 더 넓은 역할을 할 수 있음을 보여주었다. 즉, 언어는 다양한 task insruction을 명시적으로 표현하고, 이를 통해 end-to-end로 학습된 neural assistant가 관심 task로 전환하여 문제를 해결할 수 있도록 하는 universal interface가 될 수 있다. 예를들어, 최근 ChatGPT와 GPT-4의 성공은 human instruction을 따르는 데 있어 align된 LLM의 강력함을 보여주었으며, 오픈소스 LLM 개발에 대한 큰 관심을 불러일으켰다. 그 중 LLaMA는 GPT-3의 성능에 맞는 오픈소스 LLM이다. Alpaca, Vicuna, GPT-4-LLM은 기계로 생성된 다양한 고품질 instruction-following sample을 활용하여 LLM의 alignment ability를 향상시켜 proprietary LLM에 비해 인상적인 성능을 보고하고 있다. 중요한 것은 이러한 연구는 텍스트로만 이루어져 있다는 것이다.

* LLM's alignment ability : 위 문장에서의 LLM's alignment ability는 모델이 human instruction을 잘 이해하고 그에 따라 올바르게 응답하는 능력. 이를 위해 instruction-following data를 활용해 모델을 훈련.

* proprietary LLM : 상용 LLM으로 특정 회사나 단체가 독점적으로 개발하고 소유한 언어 모델

본 연구에서는 visual instruction-tuning을 제안하는데, 이는 language-image multimodal 공간으로 instruction-tuning을 확장하려는 첫 번째 시도로, 범용적인 visual assistant를 구축하는 길을 열기 위함이다. 이 논문의 contribution은 다음과 같다.

- Multimodal instruction-following data

한 가지 주요 과제는 vision-language instruction-following 데이터 부족이다. 그래서 본 논문은 ChatGPT/GPT-4를 이용하여 image-text 쌍을 적절한 instruction-following 형식으로 변환하기 위한 데이터 재구성 관점 및 파이프라인을 제시한다.

- Large multimodal models

CLIP의 visual encoder를 language decoder Vicuna와 연결하고 생성된 instructional vision-language data를 end-to-end로 fine-tuning하여 large multimodal model (LMM)을 개발한다. 실증적 연구는 LMM instruction-tuning을 위해 생성된 데이터를 사용하는 것에 대한 효율성을 검증하고 범용적인 instruction-following visual agent를 구축하기 위한 실용적인 팁을 제안한다. GPT-4와 앙상블할 때, ScienceQA multimodal reasoning dataset에서 SOTA 성능을 달성한다.

- Multimodal instruction-following benchmark

다양한 쌍의 image, instruction 및 자세한 주석이 포함된 두 가지 도전적인 벤치마크로 구성된 LLaVA-Bench를 제시한다.

- Open-source

본 연구는 생성된 multimodal instruction data, codebase, model checkpoint, visual chat demo를 공개한다.

2. Related Work

Mutimodal Instruction-following Agents

Computer Vision 분야에서 instruction-following 에이전트를 구축하는 기존 연구들은 크게 두 가지 클래스로 분류한다.

1. 각 특정 연구 주제에 대해 개별적으로 탐색되는 end-to-end 학습 모델

2. Visual ChatGPT, X-GPT, MM-REACT와 같은 LangChain / LLM을 통해 다양한 모델을 조정하는 시스템

instruction-following agent를 구축하는 데 동일한 목표를 공유하면서 여러 task들에 대해 end-to-end trained language-vision multimodal model을 개발하는 데 중점을 둔다.

Instruction Tuning

NLP 분야에서 GPT-3, T5, PaLM과 같은 LLM들이 natural language instruction을 따르고 real-world task를 완료할 수 있도록 하기 위해, 연구자들이 LLM instruction-tuning을 위해 많은 방법들을 탐색해 왔다. 이를 통해 InstructGPT/ChatGPT, FLAN-T5, FLAN-PaLM과 같은 instruction-tuned 모델들이 탄생하게 되었다. 이러한 간단한 접근 방식이 LLM의 zero-shot 및 few-shot 일반화 능력을 효과적으로 향상시킬 수 있음을 보여주었다. 따라서, NLP의 아이디어를 computer vision에 빌리는 것은 자연스러운 일이다. 보다 광범위하게는, foundation model을 사용한 teacher-student distillation idea가 image classification과 같은 다른 주제에서 연구되었다. Flamingo는 zero-shot task transfer 및 in-context-learning에 대한 강력한 성능으로 인해 multimodal domain에서 GPT-3 moment로 볼 수 있다. image-text 쌍으로 훈련된 다른 LLM에는 BLIP-2, FROMAGe 및 KOSMOS-1이 있다. PaLM-E는 embodied AI를 위한 LMM이다. 최근 best open-source LLM LLaMA를 기반으로 OpenFlamingo와 LLaMA-Adapter는 LLaMA가 image input을 사용할 수 있도록 하는 open-source 노력으로 open-source multimodal LLM을 구축할 수 있는 길을 열어준다. 이러한 모델은 유망한 task transfer 일반화 성능을 제공하지만, vision-language instruction data로 명시적으로 조정되지 않았으며 multimodal task에서의 성능은 일반적으로 language-only task에 비해 부족하다. 본 논문에서는 이러한 격차를 메우고 그 효율성을 연구하는 것을 목표로 한다. 마지막으로, visual instruction tuning은 visual prompt tuning과 다르다. 전자는 모델의 instruction-following 능력을 향상시키는 것을 목표로 하고 후자는 모델 적응의 파라미터 효율성을 향상시키는 것을 목표로 한다.

* GPT-3 moment : GPT-3가 NLP에서 혁신적인 순간을 만들어 낸 것을 의미.

* embodied AI : 'embodied'는 '구체화된' 또는 '형태를 갖춘'이라는 뜻으로 embodied AI는 단순히 데이터를 처리하는 것에 그치지 않고 실제 환경에서 동작하고 상호작용할 수 있도록 설계된 AI를 의미.

3. GPT-assisted Visual Instruction Data Generation

community는 CC에서 LAION에 이르는 image-text 쌍과 같은 public multimodal data의 양이 급증하는 것을 목격했다. 하지만, multimodal instruction-following data에 있어서는 이용가능한 양이 제한적이다. 이러한 이유 중 일부는 multimodal instruction-following data를 생성하는 과정이 시간이 많이 걸리고, 특히 human crowd-sourcing을 고려할 때 그 과정이 명확하게 정의되지 않았기 때문이다. 최근 text-annotation task에서 GPT 모델들의 성공에 영감받아, 기존에 존재하는 image 쌍 데이터를 기반으로 multimodal instruction-following data 수집을 위해 ChatGPT/GPT-4를 활용할 것을 제안한다.

* crowd-sourcing : 특정 task나 문제를 해결하기 위해 불특정 다수의 대중에게 자원을 요청하거나 참여를 유도하는 방식. 기업이나 개인이 내부 인력만으로 해결하기 어려운 문제를 여러 사람의 힘을 빌려 해결하고자 할 때 사용하는 방법.

image Xv와 이와 관련된 caption Xc가 있을 때, assistant에게 image 내용을 설명하도록 지시하는 질문 Xq를 만드는 것이 자연스럽다(좋다). GPT-4에게 질문 목록을 선별하도록 요청한다(see details in Appendix). 따라서, image-text 쌍을 instruction-following version으로 확장하는 간단한 방법은 Human : Xq Xv <STOP> Assistant : Xc <STOP>이다. 비용이 적게 들어 구축할 수 있지만, 이 단순한 확장 버전은 instruction과 응답 모두에서 다양성과 깊이 있는 추론이 부족하다.

이러한 문제를 완화하기 위해, 강력한 teacher로 language-only GPT-4 또는 ChatGPT를 활용하여 visual content와 관련된 instruction-following data를 생성한다. 구체적으로는 text-only GPT에 이미지를 visual feauture로 인코딩하기 위해, symbolic representation의 두 가지 유형을 사용한다.

(1) Captions typically describe the visual scene from various perspectives

(2) Bounding boxes usually localize the objects in the scene, and each box encodes the object concept and its spatial location

The symbolic representation은 LLM이 인식할 수 있는 sequence로 이미지를 인코딩할 수 있게 해준다. COCO image를 사용하여 세 가지 유형의 instruction-following data를 생성한다. 유형 별 예시는 Table 14의 하단에 하나씩 보여준다. 각 유형에 대해, 먼저 몇 가지 예제들을 수동적으로 디자인했다. 이 예시들은 데이터 수집 과정에서 사용된 유일한 human annotation이며, in-context-learning에서 GPT-4에 질의할 때 seed example로 사용된다.

- Conversation : 이미지에 대해 질문하는 사람과 assistant 사이의 대화형식으로 디자인한다. 답변은 마치 assistant가 이미지를 보고 질문에 답하는 듯한 톤으로 되어있다. 객체 유형, 객체 수, 객체 동작, 객체 위치, 객체 간의 상대적 위치를 포함하여 이미지의 시각적 내용에 대해 다양한 질문을 한다. 명확한 답변이 있는 질문만 고려한다.

- Detailed description : 이미지에 대한 풍부하고 포괄적인 설명을 포함하기 위해 질문 목록을 만든다. 각 이미지에 대해 질문 목록에서 하나의 질문을 무작위로 샘플링하여 GPT-4에 상세한 설명을 생성하도록 요청한다.

- Complex reasoning : 위의 두 가지 유형은 content에 중점을 두며 이를 기반으로 심층 추론 질문을 추가로 생성한다. 답변은 일반적으로 엄격한 논리를 따르는 step-by-step reasoning process를 필요로한다.

158K개의 고유한 language-image instruction-following sample을 수집했다. 이는 58K개의 conversation, 23K개의 detailed description, 77K개의 complex reasoning이 포함된다. 초기 실험에서 ChatGPT와 GPT-4의 사용을 비교하여 GPT-4가 일관되게 더 높은 품질의 instruction-following data를 제공한다는 것을 발견했다. 특히 공간적 추론 (spatial reasoning) 같은 면에서 우수했다.

4. Visual Instruction Tuning

4.1 Architecture

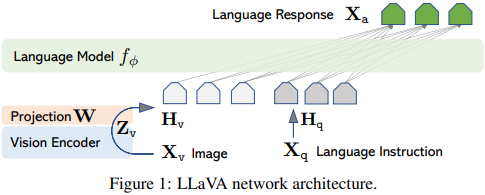

이 연구의 주요 목표는 사전 훈련된 LLM과 visual 모델에 대한 능력을 효과적으로 leverage하는 것이다. vicuna를 파라미터 φ로 이루어진 LLM으로 선택했다. 이는 공개된 checkpoint 중에서 language task에서 가장 우수한 instruction following 능력을 가지고 있기 때문이다.

input image Xv를 위해 pre-trained CLIP visual encodr ViT-L/14를 사용한다. 이는 visual feature Zv = g(Xv)를 제공한다. 그리고 실험에서 마지막 Transformer layer 전후의 grid feature를 사용한다. 이미지 특징을 단어 임베딩 공간에 연결하기 위해 간단한 linear layer를 사용한다. 구체적으로, 학습가능한 projection matrix W를 적용하여 Zv를 언어 임베딩 토큰 Hv로 변환한다. 이러한 토큰들은 언어 모델의 단어 임베딩 공간과 동일한 차원을 갖는다.

Zv=g(Xv) (g는 vision encoder), Hv=W∙Zv (W는 trainable projection matrix)

단순한 simple projection scheme는 lightweight하여 데이터 중심 실험을 빠르게 반복할 수 있다. Flamingo의 gated cross-attention이나 BLIP-2의 Q-former와 같은 더 정교한 방식으로 이미지와 언어 표현을 연결하는 방법도 고려할 수 있다. LLaVA에 대해 더 효과적이고 정교한 아키텍처 설계를 탐구하는 것은 향후 연구로 남겨둔다.

4.2 Training

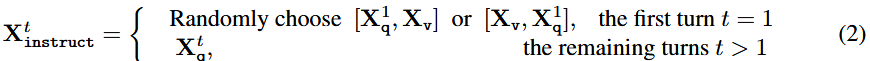

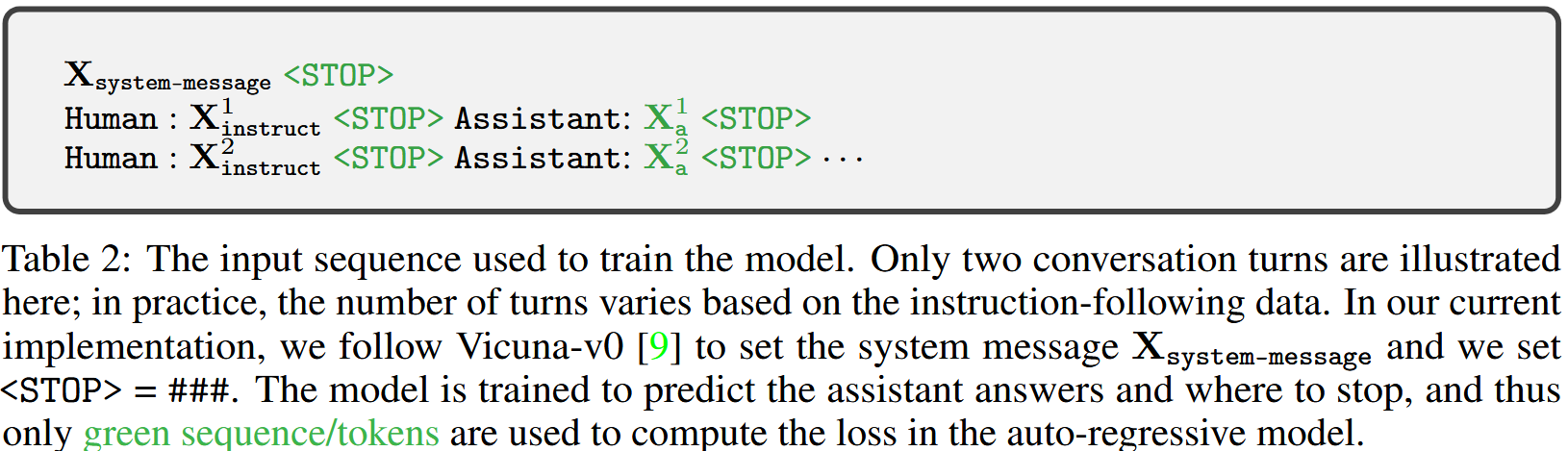

각 이미지 Xv에 대해 multi-turn conversation data를 생성한다. 여기서 T는 전체 turn 횟수이다. 모든 답변을 assistant의 응답으로 처리하고 t번째 turn의 instruction은 다음과 같이 구성하여 시퀀스로 정리한다. 첫 번째 turn인 경우, 이미지 특징을 질문 뒤에 둘지 앞에 둘지 random하게 선택한다. 나머지 turn의 경우에는 Xq^t를 사용한다.

이로 인해 Table 2에서 보여주는 multimodal instruction-following sequence의 통합 형식이 만들어진다. auto-regressive training objective를 사용하여 prediction token들에 대해 LLM의 instruction-tuning을 수행한다.

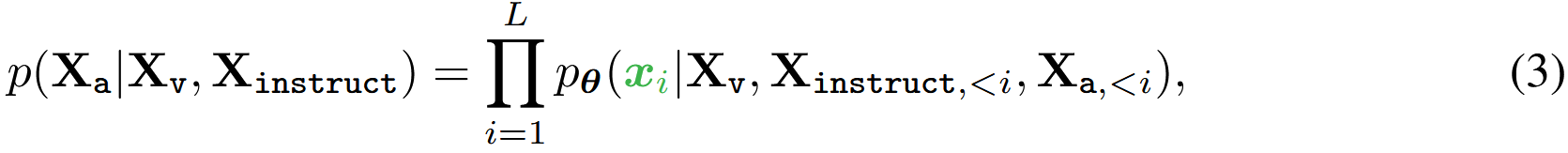

구체적으로, sequence 길이 L에 대해 target answer Xa의 확률은 다음과 같다. 여기서 θ는 학습 가능한 파라미터이고 Xinstruct, < i 와 Xa, < i 는 각각 현재 예측 token xi 이전의 모든 instruction token과 answer token이다. 예측 토큰에 대한 설명은 Table 2에서 볼 수 있다. 아래 식의 조건에서 이미지가 모든 응답에 대해 기반이 된다는 사실을 강조하기 위해 명시적으로 Xv를 추가했으며 가독성을 높이기 위해 Xsystem-message와 모든 <STOP> token을 생략했다.

LLaVA 모델 학습은 two-stage instruction-tuning 절차를 사용한다.

Stage 1: Pre-training for Feature Alignment

concept coverage와 training efficiency 간의 균형을 맞추기 위해 CC3M 데이터를 595K image-text 쌍으로 필터링한다. 필터링 과정에 대한 자세한 내용은 Appendix를 참조하면 된다. 이러한 쌍들은 Section 3에서 설명된 단순 확장 방법을 사용하여 instruction-following 데이터로 변환한다. 각 샘플은 single-turn conversation으로 취급될 수 있다. 식 (2)에서 input Xinstruct를 구성하기 위해, image Xv에 대해 question Xq가 무작위로 샘플링되는데 이는 assistant에게 이미지를 간단히 설명하도록 요청하는 language instruction이다. ground-truth prediction answer Xa는 original caption이다. 학습에서, visual encoder와 LLM 가중치들을 frozen한 상태로 두고 학습 가능한 파라미터 θ = projection matrix W만을 사용하여 식 (3)의 likelihood를 최대화한다. 이렇게 함으로써 image feature Hv는 pre-trained LLM word embedding과 align된다. 이 stage는 frozen LLM에 대해 호환 가능한 visual tokenizer를 학습하는 것으로 이해할 수 있다.

* concept coverage : 데이터가 포함하고 있는 개념의 포괄성을 의미. 즉, 여기서 concept coverage는 데이터 필터링 과정에서 다양한 개념들이 잘 포함되도록 조정하여 모델이 다양한 개념을 학습할 수 있도록 하는 것을 목표.

Stage 2: Fine-tuning End-to-End

visual encoder weight를 계속 frozen 상태로 유지하고 projection layer와 LLM의 사전학습된 가중치를 업데이트한다. 즉, 학습 가능한 파라미터 식 (3)에서 θ = {W, φ} 이다. 본 논문은 두 가지 특정 사례에 대해 고려한다.

- Multimodal Chatbot : Section 3에서 설명된 158K language-image instruction-following data에 대해 chatbot을 finetuning하여 개발한다. 세 가지 유형중에서 conversation은 multi-turn 형식이고 나머지 두 개는 single-turn 형식이다. 학습 시 이들 응답 유형은 균일하게 샘플링된다.

- Science QA : ScienceQA benchmark에서 본 논문의 방법을 연구한다. ScienceQA는 상세한 강의와 설명으로 답변에 주석을 다는 최초의 대규모 multimodal science question dataset이다. 각 질문은 자연어 혹은 이미지 context로 제공되된다. assistant는 자연어로 추론 과정을 제공하고 객관식에서 대답을 선택한다. 식 (2)에서 학습 시, 데이터를 single turn conversation 형태로 구성하며, question & context를 Xinstruct로 reasoning & answer를 Xa로 설정한다.

* 자연어 context : 질문에 대한 배경 설명이나 필요한 정보가 텍스트로 작성되어 제공.

* 이미지 context : 질문과 관련된 그림이나 사진이 제공되어, 시각적 정보로 문제를 이해하는 데 도움을 줌.

* 질문은 자연어 혹은 이미지 context로 제공된다 : assistant는 텍스트와 이미지를 활용해 질문에 대해 더 풍부하고 정확한 답변을 한다.

5. Experiments

두 가지 실험 설정인 multimodal chatbot과 ScienceQA dataset을 사용하여 instruction-following 및 visual reasoning 기능에서 LLaVA 성능을 각각 평가한다. 본 논문은 Vicuna 하이퍼파라미터에 따라 8개 A100으로 모든 모델을 훈련한다. 필터링된 CC-595K subset으로 1epoch 동안 사전학습하고 LLaVA-Instruct-158K dataset으로 3epoch동안 파인튜닝했다. 자세한 training detail은 Appendix를 참고하면된다.

5.1 Multimodal Chatbot

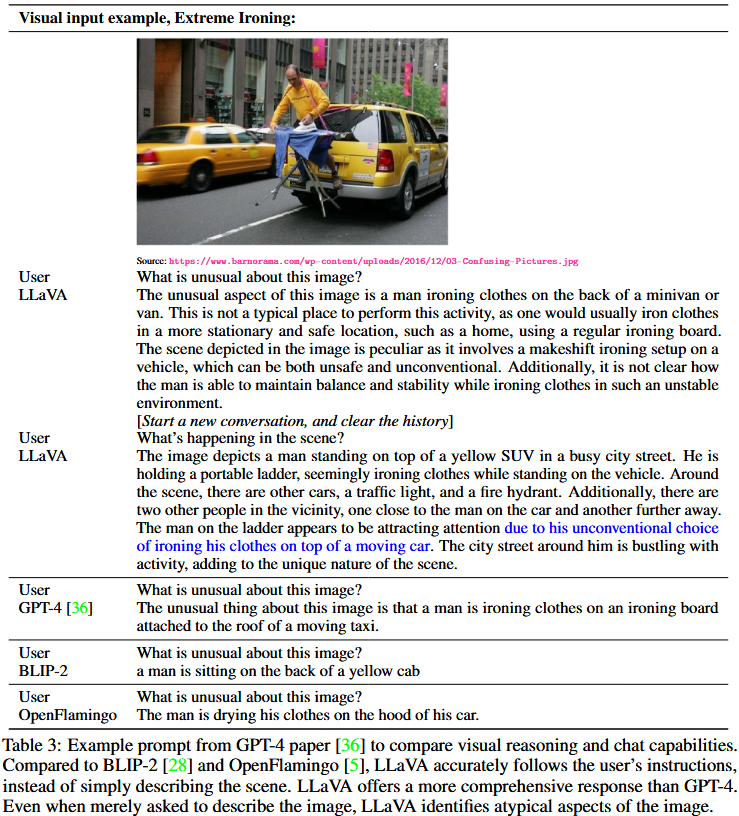

LLaVA의 이미지 이해와 대화 능력을 보여주고 LLaVA가 visual input을 얼마나 잘 소화하고 instruction-following 능력을 보여줄 수 있는지 연구하기 위해 chatbot demo를 개발했다. Table 3과 같이 처음에는 GPT-4 논문에서의 예제들을 사용했다. 이는 깊은 이미지 이해가 필요하다. 비교를 위해, 논문에서 multimodal GPT-4의 prompt와 응답을 인용하고 BLIP-2 및 OpenFlamingo model checkpoint에 query를 보내어 응답을 얻는다.

놀랍게도, 비록 LLaVA가 작은 multimodal instruction-following dataset(~80K개의 단일 이미지)로 훈련되었지만 이러한 예제들에서 multimodal GPT-4와 꽤 비슷한 추론 성능을 보여준다. 이러한 이미지는 LLaVA의 out-of-domain에 있지만 LLaVA는 여전히 장면을 이해하고 question instruction에 따라 합리적인 응답을 제공할 수 있다. 반대로, BLIP-2와 OpenFlamingo는 적절한 방식으로 응답하기 위한 user instruction을 따르는 대신 이미지 설명에 중점을 둔다.

Quantitative Evaluation

LLaVA의 성능을 체계적으로 이해하기 위해, multimodal data에서 모델의 instruction-following 능력을 측정하기 위한 정량적 지표를 제안한다. 생성된 응답의 품질을 측정하기 위해 GPT-4를 사용한다. 구체적으로, 이미지, ground-truth textual description 및 질문으로 구성된 세 가지 요소를 생성한다. 후보 모델 (e.g., LLaVA)은 질문과 이미지를 기반으로 답변을 예측한다. 대략적인 이론적 상한을 제공하기 위해, text-only GPT-4를 사용하여 질문과 ground-truth textual description을 기반으로 reference 예측을 생성한다. 즉, text-only GPT-4와 비교한다는 뜻이다. 두 개의 모델로부터 응답을 얻은 후, 질문과 visual information (텍스트 설명 형식) 및 두 assistant로부터 얻은 생성된 응답을 판단자 (i.e., text-only GPT-4)에 입력한다. 이는 assistant들의 응답에 대해 유용성(helpfulness), 관련성(relevance), 정확성(accuracy), 그리고 세부 수준(level of detail)을 평가하고 1에서 10까지의 점수로 종합 점수를 부여한다. 점수가 높을수록 전반적인 성능이 우수함을 나타낸다. GPT-4는 평가에 대한 포괄적인 설명을 제공하도록 요청받아 모델을 더 잘 이해할 수 있게 한다. text-only GPT-4 모델을 기준으로 상대 점수를 보고하며, visual input으로 textural ground truth description을 사용한다. 모델 성능을 평가하기 위해 두 가지 벤치마크를 만든다.

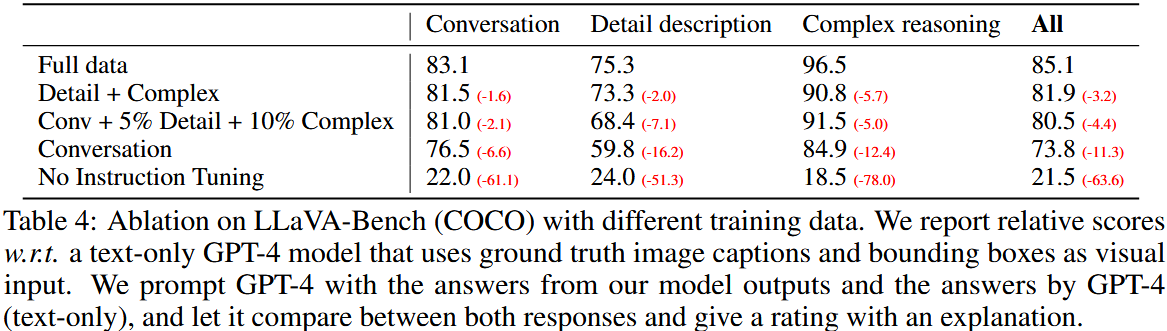

LLaVA-Bench (COCO)

COCO-Val-2014에서 30개의 이미지들을 랜덤하게 선택하고 Section 3에서 제안한 data generation pipeline을 사용하여 각 이미지에 대해 세 가지 유형의 질문(conversation, detailed description, complex reasoning)을 총 90개 생성한다. 이 벤치마크는 일관된 visual input을 통해 모델의 alignment behavior 및 capabilities를 연구한다. 다양한 유형의 instruction-following data의 효율성을 연구하기 위해 training dataset을 다양하게 변경하고 그 결과를 Table 4에서 보여준다. 첫째, instruction tuning을 통해 user instruction을 따르는 모델의 성능이 50점 이상 크게 향상된다. 둘째, 약간의 상세한 설명과 복잡한 추론 질문을 추가하면 모델의 전체 성능이 7점정도 향상된다. 또한, 대화 질문에서 모델 성능도 향상되어 추론 능력의 향상이 대화 능력을 보완한다는 것을 시사한다. 마지막으로 세 가지 유형의 데이터를 모두 보유하면 85.1%로 최고 성능을 얻을 수 있음을 보여준다.

* alignment behavior 및 capabilities : 모델이 사용자의 기대나 요구에 맞춰 얼마나 일관되게 성능을 발휘할 수 있는지를 나타내는지.

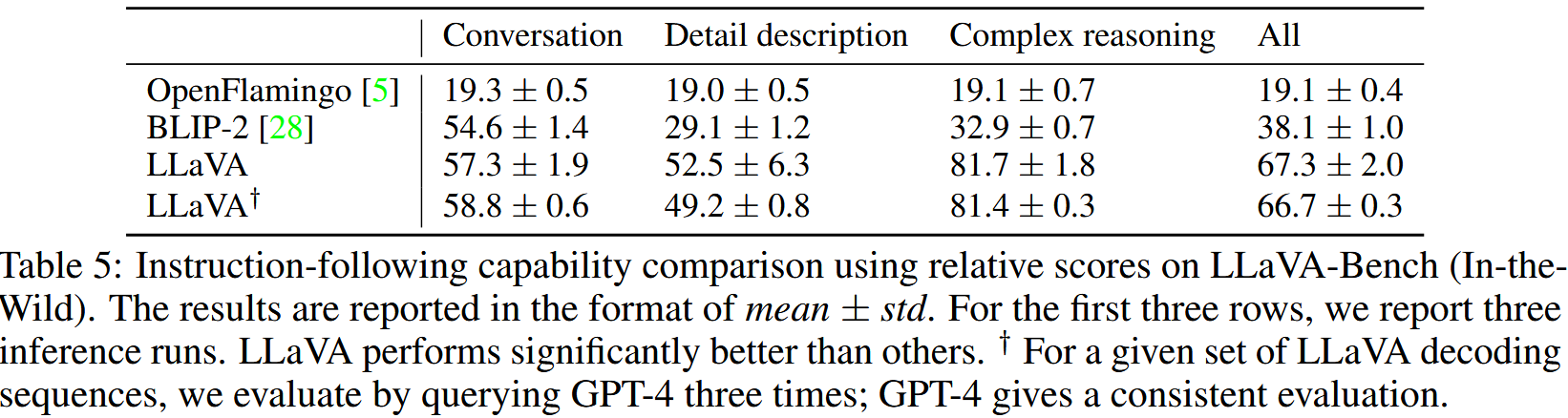

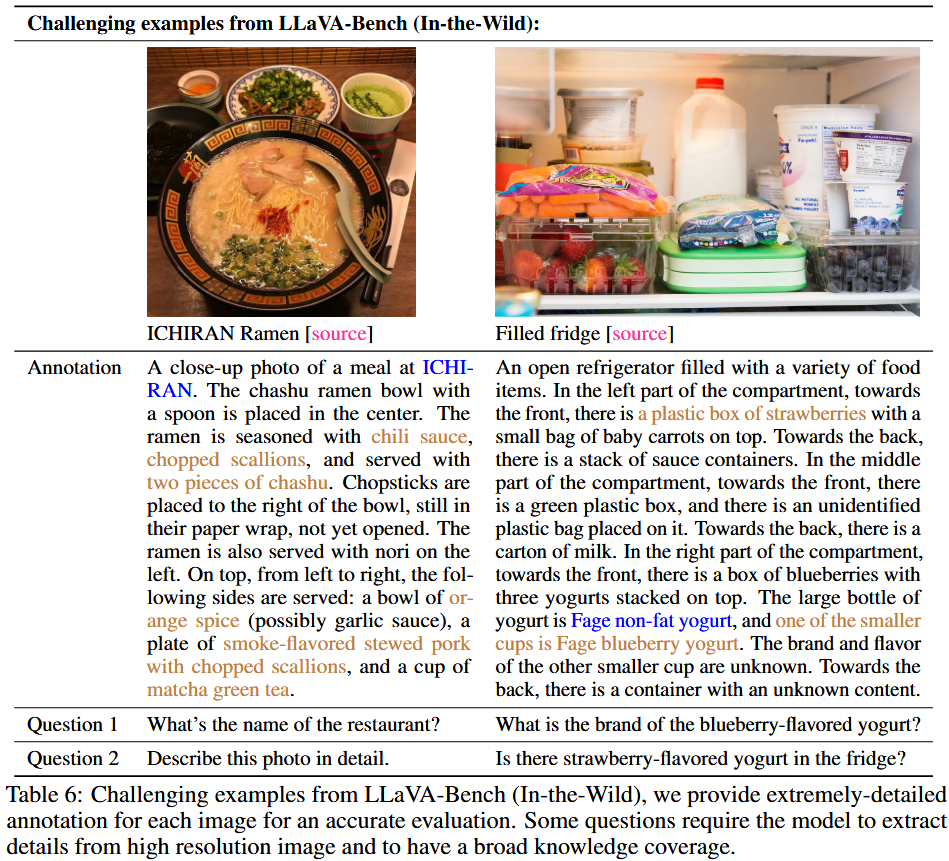

LLaVA-Bench (In-the-Wild)

보다 어려운 task에서 모델의 능력과 새로운 영역에 대한 일반화 가능성을 평가하기 위해, 실내 및 실외 장면, 밈, 그림, 스케치 등 총 60개의 질문이 포함된 다양한 24개의 이미지를 수집했다. 각 이미지에는 매우 상세하고 수동으로 신중히 작성된 설명과 적절한 질문들이 연관되어 있다. Table 5에서 LLaVA, BLIP, OpenFlamingo를 비교한다. visual instruction tuning 덕분에, LLaVA는 BLIP(+29%) 및 OpenFlamingo(+48%)에 비해 더 좋은 성능을 달성한다. ground-truth label에 접근할 수 있는 text-only GPT-4와 비교하여 LLaVA는 복잡한 추론 질문에서 81.7%의 인상적인 성능을 달성했으며 전체 점수는 67.3%이다.

Limitations

LLaVA-Bench (In-the-Wild)는 어렵고 모델의 약점을 드러내도록 설계되었다. Table 6에서 관련된 캡션과 질문과 함께 두 가지 예제를 제공한다. 식당 이름에 대해 올바르게 답변하기 위한 왼쪽 라멘 예제를 위해, 모델은 광범위한 지식 범위와 다국어 이해 능력이 필요하다. 반찬을 정확하게 설명하려면 모델이 인터넷에서 관련 multimodal 정보를 검색해야 할 수도 있다. 오른쪽 냉장고 예제의 경우, 올바른 요구르트 브랜드를 인식하려면 모델이 고해상도 이미지를 처리하고 광범위한 지식을 보유해야 한다. 또한 냉장고에 요구르트와 딸기만 들어 있음에도 불구하고 딸기맛 요구르트가 있는지 묻는 질문에 LLaVA가 'yes'라고 응답하는 흥미로운 실패 사례도 관찰했다. 이는 LLaVA가 이미지를 "bag of patches"로 인식하여 이미지 내의 복잡한 의미를 파악하지 못하는 경우가 있음을 나타낸다. LLaVA가 벤치마크의 견고한 baseline이 되어 본 논문의 연구 결과가 더 유능한 LMM을 개발하는 데 있어 향후 연구에 영감을 줄 수 있기를 바란다.

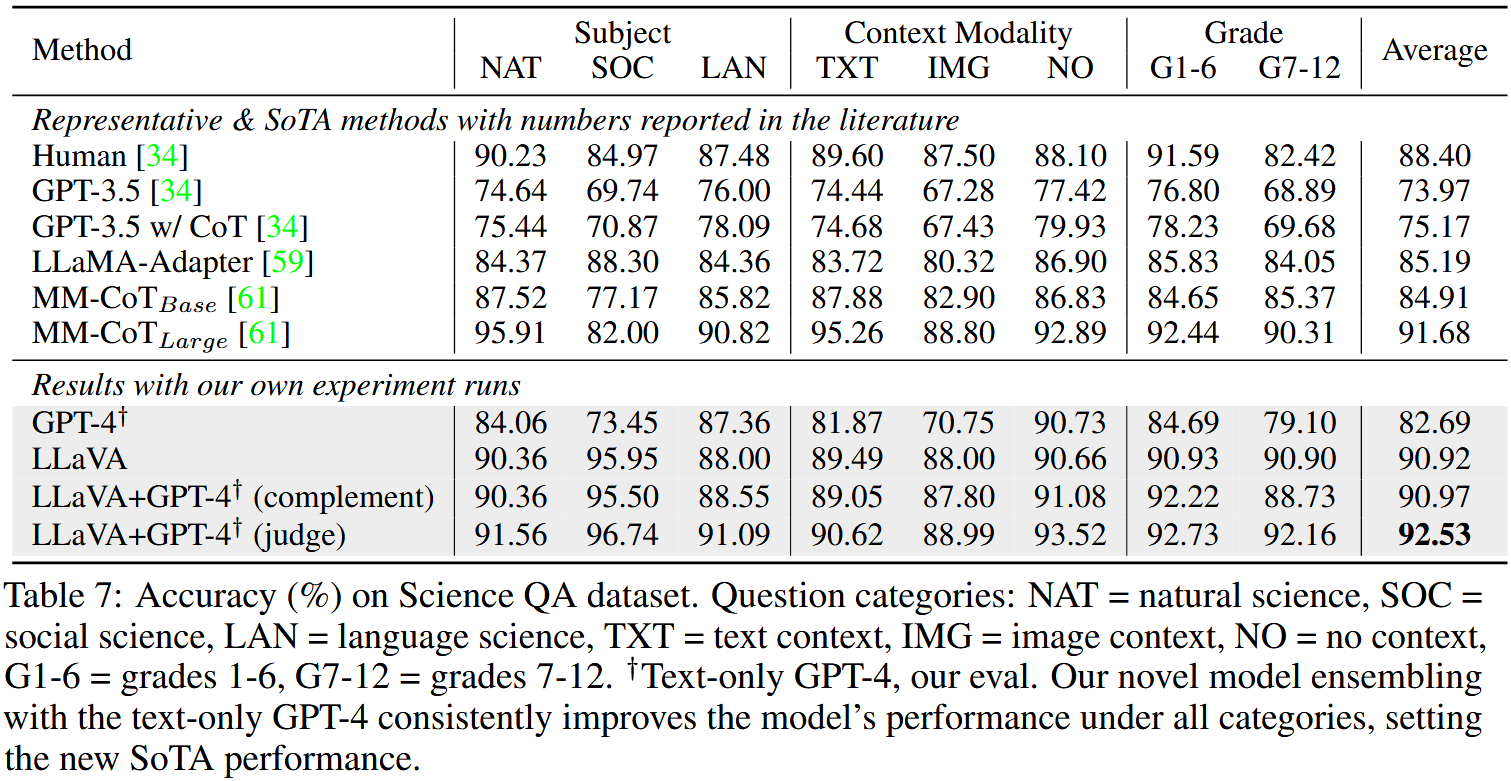

5.2 ScienceQA

ScienceQA는 3개의 주요 과목, 26개의 주제, 127개의 카테고리, 379개의 기술을 아우르는 다양한 분야의 21k개의 multimodal 객관식 질문을 포함하고 있다. benchmark dataset은 각각 12726, 4241, 4241개의 training, validation, test로 분할된다. 두 가지 대표적인 방법을 고려하는데 CoT가 포함되었거나 포함되지 않은 GPT-3.5 model (text-davinci-002), LLaMA-Adapter, 그리고 현재 이 데이터셋에서 SOTA 성능인 multimodal chain-of-thought (MM-CoT)가 포함된다.

결과는 Table 7에서 보고된다. LLaVA의 경우, last layer 이전의 visual feature를 사용하고 모델에게 먼저 추론을 예측한 후 답을 예측하도록 요청하며 12 epoch동안 학습시킨다. 이 모델은 90.92%의 정확도를 기록했으며, 이는 SOTA인 91.68%에 매우 근접하다. LLM의 한계를 탐구하기 위해, GPT-4에 2-shot in-context-learning prompt를 사용하여 실험을 했으며, 82.69%의 정확도를 달성했다. 이는 GPT-3.5의 75.17%와 비교해 7.52%의 절대적인 성능 향상에 해당한다. 상당 수의 질문에 대해 GPT-4가 단순히 이미지나 도표 등 불충분한 문맥이 있다고 보고하면서 실패하는 것을 관찰했다. 본 논문의 모델과 GPT-4의 결과를 결합하기 위해 두 가지 방식을 고려한다.

(1) GPT-4 보완 방식 : GPT-4가 답을 제공하지 못할 때마다 본 논문의 모델의 예측을 대신 사용한다. 이 방식은 90.97%의 정확도를 기록했으며, 이는 본 논문의 모델 단독 성능과 거의 동일하다.

(2) GPT-4를 판단자로 설정 : GPT-4와 LLaVA가 서로 다른 답을 제시할 때, GPT-4에게 다시 prompt를 제공하여 질문과 두 결과를 기반으로 최종 답을 내리도록 요청한다. 이 접근법은 CoT와 유사하지만, 다른 모델의 외부 지식을 함께 고려한다.

놀랍게도, 이 방식은 모든 질문 유형에 대해 성능 향상을 제공하며, SOTA 성능인 92.53%의 정확도를 달성한다. 흥미롭게도, 이미지를 처리하지 못하는 text-only GPT-4가 이미지를 문맥으로 제공된 질문에서도 모델의 전체 성능을 향상시켰다. 이는 일부 질문에서 정답을 맞히는 데 실제로 이미지 문맥이 필요하지 않기 때문이다. GPT-4 판단자는 이러한 경우를 식별해 LLaVA가 만든 일부 오류를 수정할 수 있다. 예시는 Appendix에서 확인할 수 있다. 우리가 아는 한, 이번이 GPT-4가 모델 앙상블에 사용된 최초의 사례이다. 이 발견이 향후 연구에서 LLM을 활용한 더 효과적인 앙상블 방법을 탐구하도록 장려하길 바란다.

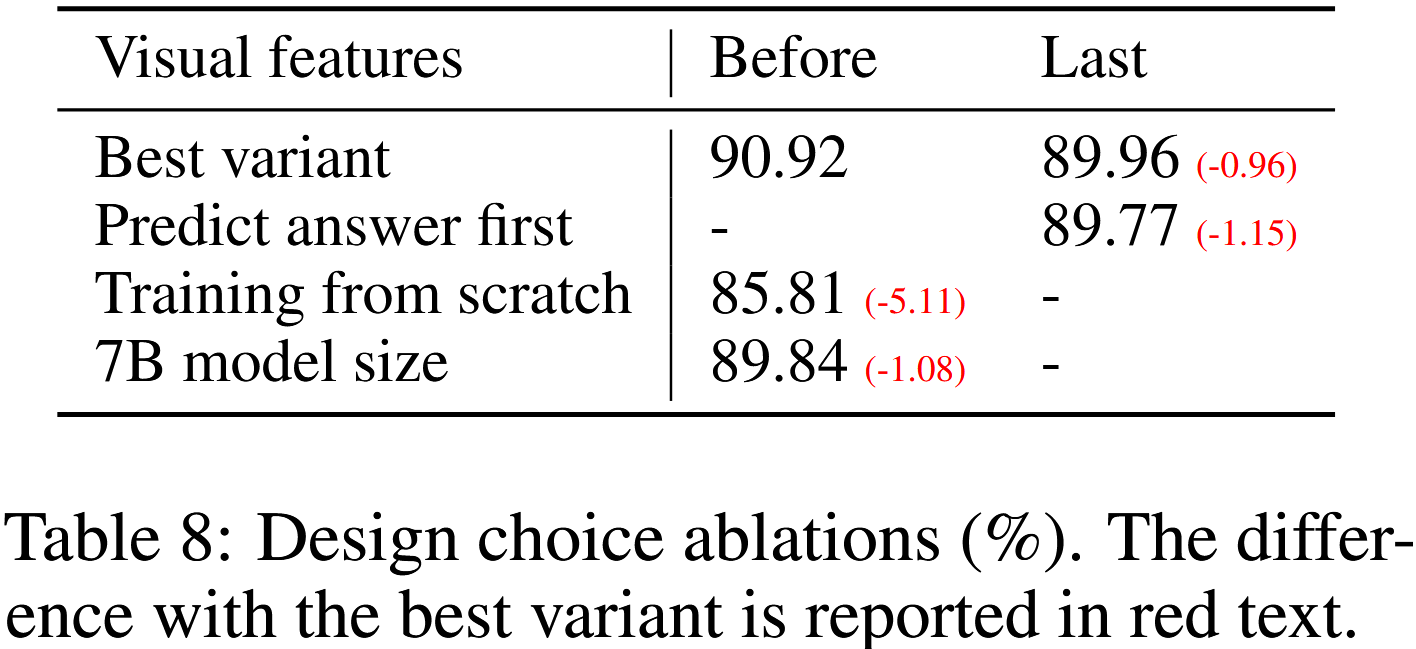

Ablations.

Table 8에서 ScienceQA에 대해 여러 design 선택을 소거 실험한다.

(1) Visual features.

CLIP vision encoder의 마지막 layer feature를 사용해보았는데 이는 89.96% 정확도를 보여준다. 이는 마지막에서 이전 layer feature를 사용할 때보다 0.96% 낮은 성능을 나타냈다. 이는 CLIP의 마지막 layer feature가 global하고 추상적인 이미지 속성에 더 집중하는 반면, 마지막 layer 이전의 feature는 특정 이미지 세부 사항을 이해하는 데 유용한 localized 속성에 더 집중하기 때문일 수 있다고 가설을 세운다.

(2) Chain-of-thought.

모델 예측에서 답변과 추론 과정의 순서를 결정하기 위해, 두 가지 방식을 실험한 결과 답변을 먼저 생성하는 방식이 12 epoch에서 89.77%의 최고 성능을 기록했다. 반면, 추론을 먼저 생성하는 방식은 6 epoch 내에 89.77% 정확도에 빠르게 도달했으나, 이후 추가 학습을 통해 성능이 더 이상 개선되지 않았다. 모델을 24 epoch동안 학습해도 성능 향상은 없었다. 따라서 CoT와 유사한 추론 우선 방식이 학습 속도를 크게 향상시킬 수 있지만, 최종 성능에는 큰 영향을 미치지 않는다.

(3) Pre-trianing.

사전학습을 생략하고 Science QA dataset에 대해 처음부터 바로 학습을 시작했으며, 이 경우 85.81% 정확도로 떨어졌다. 5.11% 성능 감소는 multimodal feature를 align하면서도 사전학습된 방대한 지식을 보존하는 사전학습 단계의 중요성을 나타낸다.

(4) Model size

모든 설정을 최고 성능을 보였던 13B 모델과 동일하게 유지하고 7B 모델을 학습시킨 결과 89.94% 정확도를 기록했다. 이는 90.92%보다 1.08% 낮은 성능으로 모델 크기가 성능에 중요한 영향을 미침을 보여준다.

6. Conclusion

본 논문은 visual instruction tuning의 효과를 입증했다. language-image instruction-following data를 생성하기 위해 자동생성 파이프라인을 제시하였다. 이를 바탕으로 LLaVA라는 multimodal model을 학습하여 visual task를 수행하기 위해 인간의 의도를 따르도록 하였다. ScienceQA를 파인튜닝할 때, 새로운 SOTA를 달성하고 multimodal chat data를 파인튜닝할 때, 뛰어난 visual chat 능력을 얻을 수 있다. 이외에도, multimodal instruction-following 능력을 연구하기 위한 첫 번째 벤치마크를 제시한다. 본 논문은 visual instruction tuning의 초기 단계이며 주로 real-life task에 중점을 둔다. 학문적 벤치마크에 대한 LLaVA의 더 많은 정량적 결과를 보려면 visual instruction tuning을 통해 개선된 baseline을 참조하면 된다. 본 연구가 더 유능한 multimodal model을 구축하기 위한 향후 연구에 영감을 줄 수 있기를 바란다.

본 논문에서는 Insturction tuning의 효과를 입증하기 위해 GPT-4를 활용한 데이터 자동생성 파이프라인을 제시하였다.

Fine-tuning된 LLaVA 모델은 ScienceQA에서 SOTA 성능을 달성하였다.

저자는 다음과 같은 후속 연구 주제를 남겨두었다.

1. 모델에 사용된 image-text 데이터는 아주 일부분으로 더 큰 데이터셋을 가지고 사전훈련과 다양한 데이터 생성 파이프라인을 이용한 fine-tuning은 더 유망한 모델로 연결될 것이다.

2. SAM과 같은 더 강력하고 다양한 시각 모델들의 연결을 통해 현재 모델이 갖지 못한 새로운 기능을 활성화하는 것을 추구한다.

Appendix

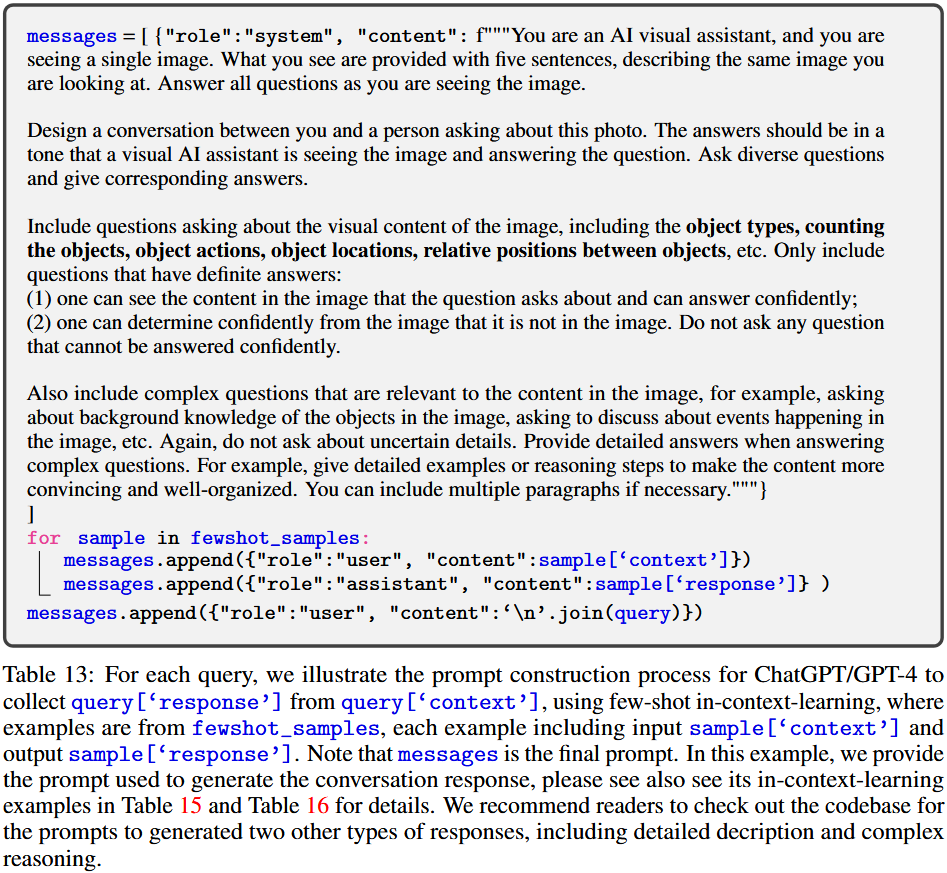

F. Prompts

Table13은 각 query에 대해 ChatGPT/GPT-4의 응답을 수집하기 위해 query['context']에서 query['response']로 가는 prompt 구성 과정을 설명한다. 이를 위해 few-shot in-context-learning을 사용하며 예시는 fewshot_samples에서 가져오며 각 예시는 input (sample['context'])와 output (sample['response'])을 포함한다. messages는 최종 prompt를 나타낸다. 이 예제에서는 대화형 응답을 생성하기 위해 사용된 prompt를 제공하며 in-context-learning 예시는 Table 15와 Table 16에서 자세히 확인할 수 있다. 또한, 두 가지 다른 유형의 응답을 생성하는 prompt(상세 설명 및 복잡한 추론)을 확인하려면 codebase를 참조하기를 바란다.